Problemas de salud como el ataque cerebrovascular o la esclerosis lateral amiotrófica (ELA) pueden alterar la capacidad de hablar como secuela. En los Estados Unidos, por separado, dos equipos de investigadores consiguieron colocar implantes de lectura cerebral que fueron mejorados mediante inteligencia artificial (IA).

Estos dispositivos lograron que dos personas con parálisis pudieran comunicarse con una precisión y rapidez sin precedentes. Ambos avances fueron publicados a través de dos estudios en la revista Nature.

En sus reportes, los equipos de investigación describieron las interfaces cerebro-ordenador que traducen señales neuronales en texto o palabras pronunciadas por una voz sintética.

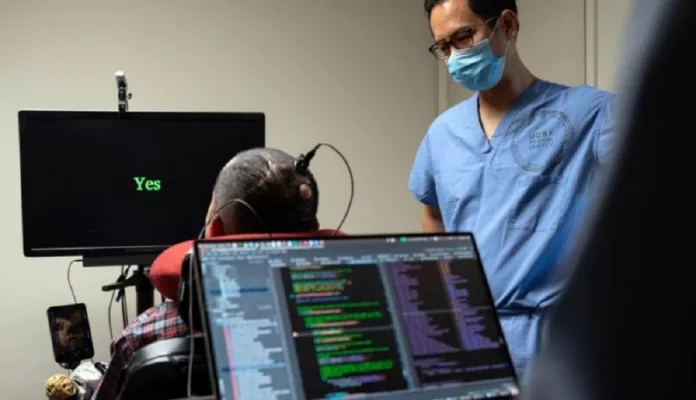

Pat Bennett, de 67 años, tiene esclerosis lateral amiotrófica y accedió a una investigación con una técnica de implante cerebral con inteligencia artificial (UCSF / Steve Fisch)

Ese tipo de interfaces pueden decodificar el habla a 62 y 78 palabras por minuto, respectivamente. La conversación natural se produce a unas 160 palabras por minuto, pero las nuevas tecnologías son más rápidas que cualquier intento anterior.

“Ahora es posible imaginar un futuro en el que podamos devolver la conversación fluida a alguien con parálisis, permitiéndole decir libremente lo que quiera con una precisión lo bastante alta como para que se le entienda con fiabilidad”, afirmó Francis Willett, neurocientífico de la Universidad de Stanford, California, Estados Unidos y coautor de uno de los trabajos.

El científico Willett y sus colegas desarrollaron una interfaz para interpretar la actividad neuronal a nivel celular y traducirla a texto. La paciente fue Pat Bennett, de 67 años, quien fue diagnosticada con esclerosis lateral amiotrófica, una dolencia que provoca una pérdida progresiva del control muscular, con las consiguientes dificultades para moverse y hablar.

Los investigadores insertaron conjuntos de pequeños electrodos de silicio en partes del cerebro de Bennett que intervienen en el habla, un par de milímetros por debajo de la superficie.

Luego, entrenaron algoritmos de aprendizaje profundo para reconocer las señales únicas en el cerebro de la paciente cuando intentaba pronunciar varias frases utilizando un conjunto de vocabulario grande de 125.000 palabras y un conjunto de vocabulario pequeño de 50 palabras.

La IA decodifica palabras a partir de fonemas, las subunidades del habla que forman las palabras habladas. Para el vocabulario de 50 palabras, la interfaz funcionó 2,7 veces más rápido que una otra anterior de última generación y alcanzó una tasa de error de palabras del 9,1%.

La tasa de error se elevó al 23,8% para el vocabulario de 125.000 palabras. “Aproximadamente tres de cada cuatro palabras se descifran correctamente”, declaró Willett en una conferencia de prensa.

“Para las personas que no hablan, esto significa que pueden seguir conectadas con el mundo en general, tal vez seguir trabajando, mantener amistades y relaciones familiares”, contó la paciente Bennett.

Mientras tanto, Edward Chang, neurocirujano de la Universidad de California en San Francisco, y sus colegas contaron en su estudio que trabajaron con una mujer de 47 años llamada Ann, que perdió la capacidad de hablar tras sufrir un ataque cerebrovascular hace 18 años.

Utilizaron un método distinto al del equipo de Willett. Colocaron un rectángulo delgado como un papel que contenía 253 electrodos en la superficie de la corteza cerebral. La técnica, denominada electrocorticografía (ECoG), se considera menos invasiva y puede registrar la actividad combinada de miles de neuronas al mismo tiempo.

El equipo entrenó algoritmos de IA para reconocer patrones en la actividad cerebral de Ann asociados a sus intentos de pronunciar 249 frases con un vocabulario de 1.024 palabras. El dispositivo produjo 78 palabras por minuto con una tasa media de errores de palabra del 25,5%.

Aunque los implantes utilizados por el equipo de Willett, que captan la actividad neuronal con mayor precisión, superaron este resultado con vocabularios más amplios, es “agradable ver que con ECoG es posible lograr una tasa baja de errores en las palabras”, resaltó Blaise Yvert, investigador en neurotecnología del Instituto de Neurociencia de Grenoble, en Francia.

Chang y su equipo también crearon algoritmos personalizados para convertir las señales cerebrales de la paciente en una voz sintética y un avatar animado que imita las expresiones faciales. Personalizaron la voz para que sonara como la de Ann antes de su lesión. La entrenaron con grabaciones del video de su boda.

“El simple hecho de oír una voz parecida a la tuya es emocionante”, dijo Ann a los investigadores en una sesión posterior al estudio. “¡Cuando tuve la capacidad de hablar por mí misma fue enorme!”, agregó.

“La voz es una parte realmente importante de nuestra identidad. No sólo tiene que ver con la comunicación, sino también con quiénes somos”, comentó Chang.

Pese a las ventajas que las pacientes han encontrado, se necesitan muchas mejoras antes de que los implantes cerebrales puedan estar disponibles para uso clínico. “Lo ideal sería que la conexión fuera inalámbrica”, explicó Ann a los investigadores. Una interfaz adecuada para el uso cotidiano tendría que ser un sistema totalmente implantable, sin conectores ni cables visibles, añadió Yvert.

Ambos equipos esperan seguir aumentando la velocidad y precisión de sus dispositivos con algoritmos de descodificación más robustos.

Según Herff, los participantes en ambos estudios siguen siendo capaces de activar los músculos faciales cuando piensan en hablar y sus regiones cerebrales relacionadas con el habla están intactas. Aunque reconoció que eso no ocurre en todos los pacientes.

“Lo vemos como una prueba de concepto y como una motivación para que los industriales de este sector lo conviertan en un producto que alguien pueda utilizar”, explicó Willett.

Los dispositivos aún deben evaluarse en ensayos clínicos con muchas más personas para demostrar su fiabilidad. “Por muy elegantes y sofisticados que sean estos datos desde el punto de vista técnico, tenemos que entenderlos en su contexto, de forma muy mesurada”, afirma Judy Illes, investigadora en neuroética de la Universidad de Columbia Británica en Vancouver, Canadá.

“Tenemos que tener cuidado con la generalizabilidad excesivamente prometedora a grandes poblaciones”, añadió. Más optimista, Christian Herff, neurocientífico computacional de la Universidad de Maastricht, en los Países Bajos, opinó que los implantes cerebrales “podrían ser productos en un futuro muy próximo”.